Corso IA consapevole 2026

Uno guardo critico sull' IA generativa

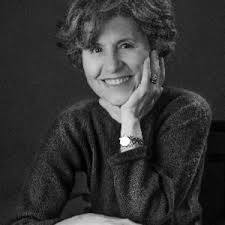

Intervento di Michela Fontana

Considero ChatGPT - pur riconoscendo alcuni suoi utili impieghi in ambito aziendale o della ricerca- come l’ennesimo strumento dell’intelligenza artificiale destinato a impoverire la nostra intelligenza, a spegnere la nostra creatività e capacità di pensiero autonomo. E soprattutto destinata a soffocare lo spirito critico, la capacità squisitamente umana alla base di ogni presa di coscienza responsabile.

Chat GPT nelle sue diverse versioni, così come tutti gli altri LLM ( Large language models, modelli linguistici di grandi dimensioni, chatbot come Gemini, Claude…..) non ha alcuna forma di intelligenza, non capisce quello che scrive o dice, non sa distinguere il vero dal falso, ma riesce a simulare in modo accurato il nostro linguaggio, grazie ad algoritmi statistici e all’ “addestramento”, basato su un enorme quantità di dati. Dati ( parole frasi conversazioni..) che noi utenti abbiamo prodotto negli anni, scrivendo sui social, facendo ricerche in rete, ma anche i dati che sono stati ricavati da tutto quello che è stato pubblicato, ( libri, articoli..). E tutto ciò senza informare gli utenti, o pagare diritti a scrittori, giornalisti, editori. Del resto gli stessi dati ricavati dalla rete, (catturati da ogni dispositivo che maneggiamo collegato a internet) consentono da più di venti anni alle aziende di di catalogare ogni individuo, in base a gusti, tendenze, abitudini, preferenze politiche e sono raccolti e usati senza la nostra consapevolezza o autorizzazione, per inviarci pubblicità mirate. Come bene ha illustrato il fondamentale volume“ Capitalismo della sorveglianza “ scritto dalla docente di Harvard Shoshana Zuboff ( 2019).

Tutti usiamo da anni i prodotti della digitalizzazione, che rendono in molti casi più veloce il lavoro e la ricerca di informazioni. Io stessa uso i motori di ricerca, ma cerco di farlo in modo vigile confrontando le fonti online, e sempre mi documento su libri di autori qualificati o su articoli scientifici o di giornali e riviste che verificano a loro volte le notizie, ovvero dichiarano le fonti e sono responsabili di ciò che pubblicano. Chi ha avuto la fortuna di apprendere a scuola o in università un metodo di studio basato sui libri e sul rispetto delle fonti e sulla precisione delle informazioni, non si capisce perché dovrebbe delegare scelte e decisioni ad una macchina. Che molto spesso sbaglia, e che produce i suoi risultati aggiustando e combinando testi già esistenti. Perché rinunciare al nostro cervello ? Perchè farlo atrofizzare ? Perché rinunciare allo spirito critico e al nostro pensiero originale?. Perché siamo così disposti alla passività ?.

Molti hanno abbracciato a suo tempo con entusiasmo la rete, i motori di ricerca, i social , gratuiti e divertenti, pensando che comunicare con tutti fosse un segnale di libertà, di arricchimento. C’è stato tanto entusiasmo e troppa ingenuità. Ma perché erano gratuiti i social? Pochi se lo sono chiesti Ora si sa, grazie a numerosi studi , che i social, non solo servono a estrarre dati dagli utenti ignari, ma usano algoritmi realizzati di proposito per influenzarci, e renderci dipendenti dal loro uso. Le grandi aziende tecnologiche come Meta-Facebook hanno introdotto i social gratuiti perché ogni nostro like, commento, interazione, ogni minuto che trascorriamo in rete è per loro un guadagno. Solo in questo modo si spiegano i loro ricavi stratosferici, addirittura maggiori del prodotto interno lordo di alcuni stati.

Non solo, ma è ormai dimostrato che l’uso esteso dei social sta danneggiando in modo significativo lo sviluppo psichico dei giovani. Non solo sono stati progettati per creare dipendenza , ma favoriscono anche dinamiche e interazioni che provocano ansia, aggressività, insonnia. Passare ore sui social distrugge la capacità di concentrazione, abitua a scambi veloci ed effimeri, depotenzia le funzioni cerebrali. Tanto che si sta legiferando nel mondo per limitarne o vietarne l’uso al di sotto di una certa soglia di età E’ anche stato dimostrato che i social hanno il potere di influenzare le persone, e sono stati usati in questo senso, non solo per orientare all’acquisto, ma per indirizzare le scelte politiche . I danni che possono produrre i social, dobbiamo saperlo, saranno straordinariamente amplificati dall’introduzione sempre più massiccia e capillare delle intelligenze artificiali, inclusi i Large language models come ChatGPT. Con conseguenze potenzialmente devastanti se non si introducono regolamentazioni opportune a protezione degli utenti.

Eppure, come a suo tempo i social, anche gli strumenti più recenti di IA non sono stati sottoposti a sufficienti controlli sugli effetti del loro uso generalizzato e prolungato, prima di venire messi sul mercato.

A mettere in guardia sui possibili effetti negativi dei nuovi strumenti tecnologici sono molti tra gli stessi scienziati che hanno contribuito a svilupparli. Ad esempio Mustafa Suleiman, cofondatore di Deep Mind e Inflection AI e ora Ceo di Microsoft AI, nel libro L’onda che verrà ( 2023). Suleiman sostiene che il progresso tecnologico non si può e non si deve fermare. Ma - avverte- dati i pericoli a cui l’umanità va incontro adottando la tecnologia più dirompente della storia , che affiderà alle macchine compiti fino a ieri squisitamente umani, è urgente occuparsi del suo “contenimento” diffondendo consapevolezza e adottando regole precise per il suo uso.

Non soltanto i LLM possono compiere errori,( io preferisco chiamarli così e non allucinazioni , termine quasi consolatorio), incluso il nuovo Chat GPT Health, specializzato a su temi medici, come si può leggere in recenti studi. E’ stato verificato che i chatbot possono contenere pregiudizi propri della cultura all’interno della quale sono stati addestrati. Ad esempio pregiudizi di genere e nei confronti delle minoranze.

Inoltre, dal momento che sono addestrati anche per simulare empatia, possono influenzare psicologicamente chi li sua. Soprattutto i giovani. Negli Stati Uniti si sono verificati suicidi di ragazzi dopo interazioni con ChatGPT-4, e alcuni genitori hanno intentato cause legali. OpenAI, che produce ChatGPT ha risposto di non essere responsabile dell’uso che gli utenti fanno dei suoi strumenti. Eppure la dipendenza patologica che alcuni giovani dimostrano verso i chatbot non è casuale: è progettata. Anche le aziende produttrici di sigarette sapevano che il fumo creava dipendenza, ma volutamente lo ignoravano. E sono state , pur in ritardo, ritenute responsabili dei danni provocati.

Ho appreso che, per migliorare le risposte di ChatGPT , ci viene suggerito di “ educarlo”, ad esempio riproponendo le domande in modo sempre più preciso, oppure chiedendo-gli ( chiedendo-le? ) di essere più onesto o meno adulatore.Non capisco perché dovremmo farlo. Meglio educare un giovane, meglio confrontarsi con una persona in carne ed ossa. Meglio impiegare quella fatica per spiegare ai giovani come sia importante mantenere consapevolezza e sviluppare lo spirito critico, invece di affidarsi ciecamente ai modelli di IA pensando che siano infallibili, o che possiamo renderli tali. Non lo sono. Non lo saranno mai. E non sanno cosa sia l’empatia, si limitano a simularla. E poi perché dialogare con una macchina invece di fare una ricerca in prima persona? Perché siamo tutti così pronti entusiasticamente a seguire il pifferaio di Hamelin verso il precipizio?

Concludo con un’ esemplificazione piuttosto divertente a conferma di quanto ho sostenuto, offertami inaspettatamente proprio dal chatbot.

Quanto ho appena esposto qui sopra è una parziale sintesi del mio commento, pronunciato a braccio, durante la prima giornata dell’incontro Ai consapevole, dedicata, appunto, a ChatGPT. Ebbene, il riassunto del mio breve intervento mi è stato gentilmente spedito per mail dalla organizzatrice perché lo sistemassi per la pubblicazione. Il testo inviatomi mi suonava un pò falso, sapeva di rielaborazione non pensata, non accurata, anche se i temi da me trattati c’erano tutti.

Infatti non era una semplice sbobinatura, ma nemmeno un riassunto preparato da un umano. Era stato elaborato, ironia della sorte, come mi hanno confermato, proprio da ChatGPT! Forse una vendetta dell’IA nei miei confronti? Non proprio riuscita, dal momento che l’elaborato conteneva un madornale errore. Io avevo citato il libro di Mustafa Sueiman “L’onda che verrà”. ChatGPT scrive invece : “ Il mondo che verrà” e aggiunge “consigliato anche da Umberto Eco” (sic!!) Peccato che il titolo sa sbagliato e peccato che Umberto Eco sia morto 7 anni prima della pubblicazione di “L’onda che verrà”. ! Inutile dire che ho interamente riscritto la traccia inviatami da ChatGPT.

Michela Fontana, matematica, giornalista e saggista, è autrice di numerose opere, tra cui: Percorsi calcolati (1996), Matteo Ricci (2005), Cina. La mia vita a Pechino (2008), Nonostante il velo (2015).

Scrive di Intelligenza artificiale sul blog Coolmag:

https://www.coolmag.it/category/letture/

Milano 8 febbraio 2026